Но выкладывать её в открытый доступ компания не планирует.

Но выкладывать её в открытый доступ компания не планирует.

О нейросети MusicLM разработчики из Google рассказали на GitHub. Они не планируют делать её доступной или выкладывать исходный код. Но «для поддержки будущих исследований» они опубликовали набор из 5,5 тыс. пар «музыка-текст».

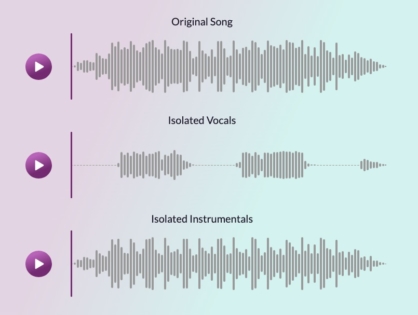

MusicLM обучили на 280 тыс. часах музыки, чтобы та могла создавать связные песни для «сложных» описаний. Нейросеть генерирует мелодии на частоте 24 кГц, которая остается неизменной в течение нескольких минут.

В качестве примеров исследователи приводят музыку для аркадной игры, песню, которая вызывает «ощущение, что ты затерялся в космосе», мелодию для медитации и другие.

Кроме того, исследователи создали музыку по описанию картин Сальвадора Дали, Анри Матисса, Эдварда Мунка, Пабло Пикассо и других известных художников.

Разработчики отметили, что с нейросетью может быть связано много этических проблем — например, они обнаружили, что 1% сгенерированной музыки напрямую повторяет мелодии из набора для обучения. Этого уже достаточно, чтобы не выпускать MusicLM в открытый доступ из-за возможных проблем с авторским правом.

Компания не первая, кто создаёт подобные нейросети: например, OpenAI представила модель Jukebox в 2020 году, а у самой Google уже есть нейросеть для генерации мелодий на основе звуковых подсказок AudioML.

ИСТОЧНИК: VC

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.